背景

近期,Kimi 上线了 “深度研究”(Deep Research)功能。我正好用它来解决一个实际的调研需求:AI Code Review 的工具调研。

为了更全面的视角,我同步对比测试了 Gemini Deep Research 和 Manus。

最终体验下来我的排序是:Gemini Deep Research > Kimi 深度研究 > Manus。这个结果正好引起了对当前 “通用 Agent” 思考。

Kimi 深度研究:你很努力了

在 Kimi 中,我提出的问题是:研究 AI Code Review 领域的产品有哪些,列举出它们各自的优势、用户体量。

Kimi 首先进行了程式化的反问:

为了更精准地为您梳理AI Code Review领域的产品及其优势、用户体量,能否请您明确以下两点:

- 您主要关注哪些类型的AI Code Review工具?例如,是集成在IDE中的辅助工具、独立的代码审查平台,还是特定于某种编程语言或技术栈的专用工具?

- 在评估“优势”时,您最看重哪些方面?比如,是审查的准确性和深度、对特定编程语言的支持、与现有开发工具的集成能力、易用性和学习曲线,还是成本效益?

坦白说,这类反问在开放式调研中意义有限——我期待的恰恰是 Kimi 能主动扩大我的思考边界,发现我没有提到的方向,而不是把必要的研究点罗列出来要我选择。

Kimi 的研究过程遵循标准循环:思考 -> 执行工具 (搜索/浏览器) -> 思考...

不过 “使用浏览器” 工具的使用,也挺令人困惑:一次搜索返回 20~30 个结果,却只对其中 一篇 执行 “使用浏览器”。对于研究类任务,原材料应该来自于调研报告、评测文章等等,它们不需要操作浏览器来获取。

更明显的问题大概是记忆管理能力缺失:

- 后续搜索重复抓取已研究产品(如 GitHub Copilot)。

- 中途生成了仅含

return "研究总结文本..."的 Python 代码,下一步却又重回搜索。

最终报告列举了 GitHub Copilot, Bito, Continue 等产品,但遗憾地遗漏了 Amazon CodeGuru, Fixie 等研究过程中出现过的产品,并错误地将 CodeRabbit 和 Windsurf 混为一谈。

不过,Kimi 生成的网页报告在呈现美观度上确实可圈可点。

Manus 研究:大材小用

在 Manus 上我尝试了两次。

第一次: 浅尝辄止。Manus 仅执行了 3 次搜索,报告仅涵盖 3 款产品,深度广度均不足。

第二次任务: 我细化了要求,希望能规避第一次深度广度不足的问题:Do research on AI Code Review tools/products, should based on the analytic and review article, focus on the product features, users, pricing, market shares. Do extensive research。

初始计划不错,显示出理解任务目标:

I will do the following:

- Search for AI code review tools and market analysis

- Analyze product features and capabilities

- Research user base and target markets

- Investigate pricing models and market positioning

- Analyze market shares and competitive landscape

- Compile comprehensive research report

Manus 显著的特点是记忆。“边搜索边本地记录” 的机制有效解决了模型记忆的痛点。然而,对 “使用浏览器”的依赖近乎偏执——几乎每次搜索后必用。这直接导致任务在浏览某个网页时彻底卡死,无法恢复,最终被迫放弃。工具的错误选择,反而成了可靠性的绊脚石。

Gemini Deep Research:足够专业

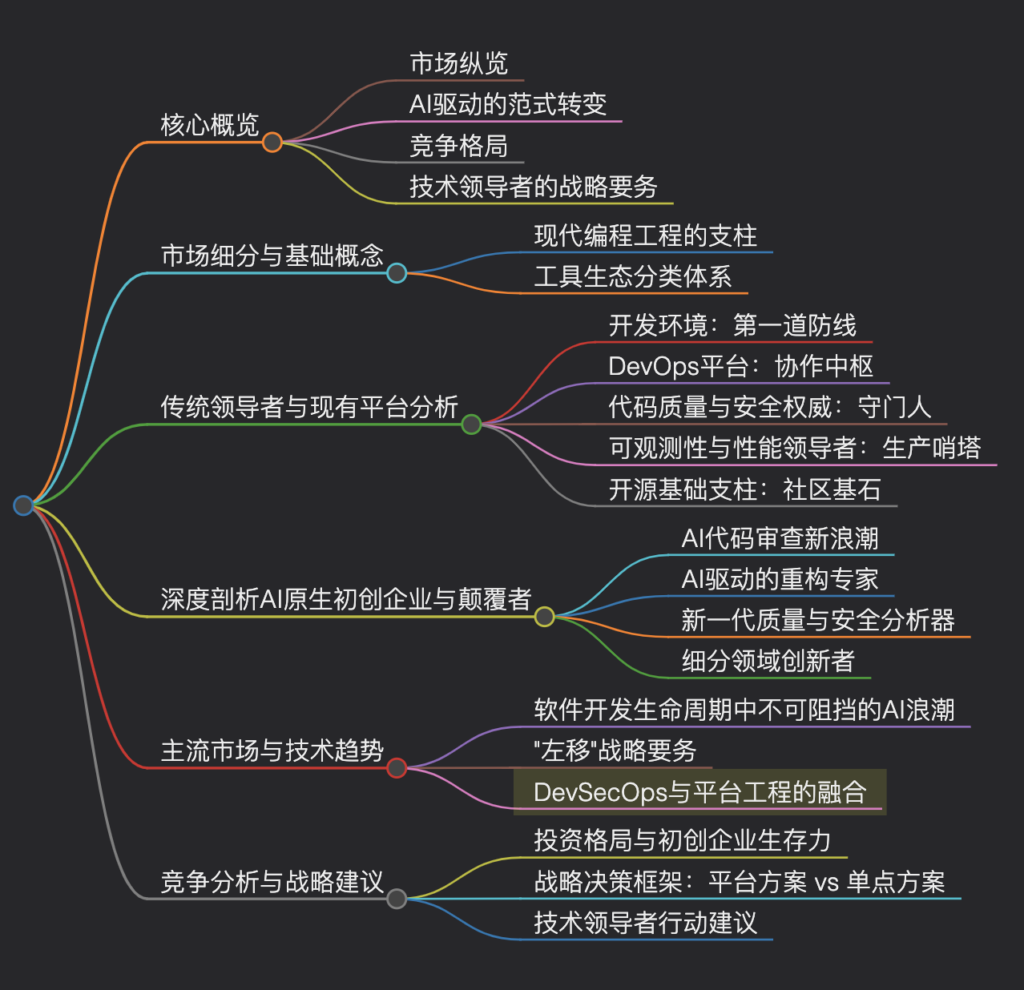

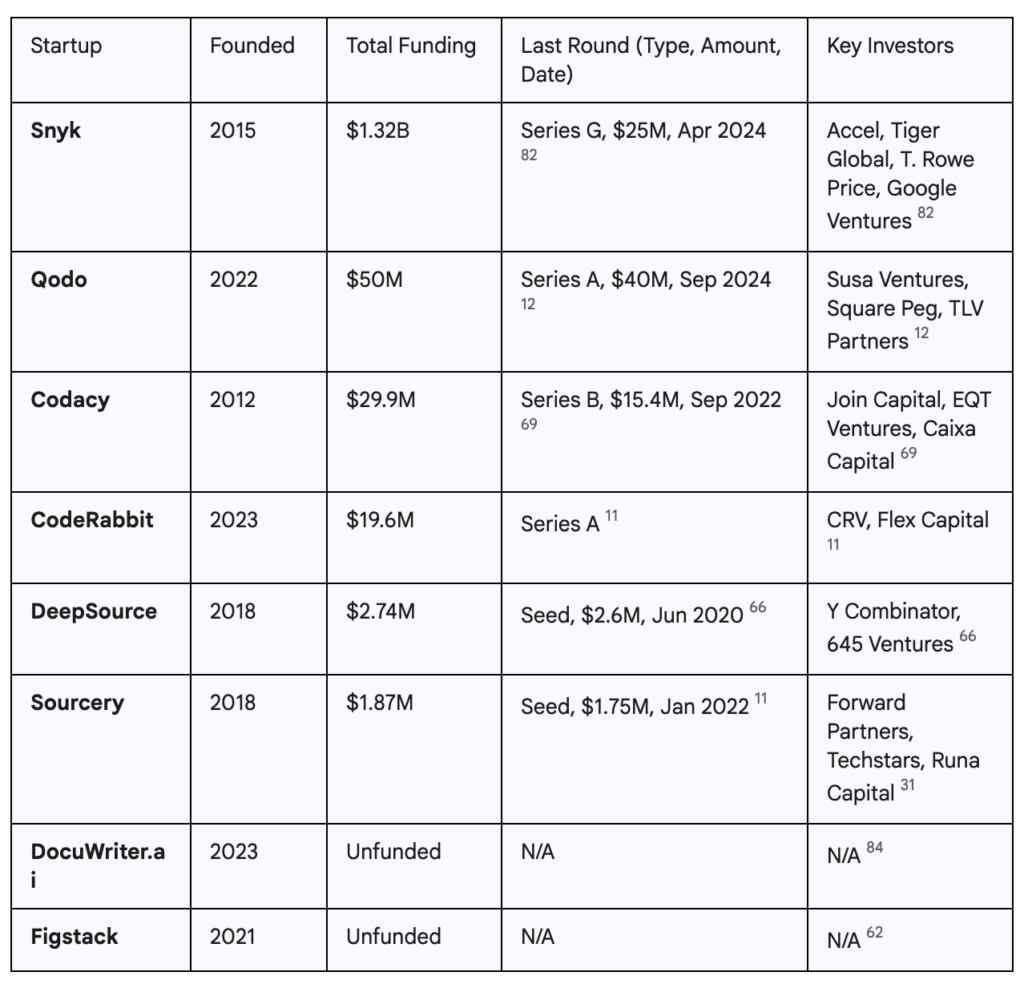

对比之下,Gemini Deep Research 展现出更高的成熟度。研究过程稳定流畅,最终报告结构清晰、体系化。虽然也存在产品遗漏,但整体体验的连贯性和结果的可预期性明显胜出。 它证明了在特定任务上做深做透的价值。

总结与思考:通用还是专业化

Manus 的爆火,象征着市场对 “一个 Agent 解决所有问题” 的乌托邦式期待。创业叙事偏爱 “通用性” 的宏大蓝图,这本无可厚非。

然而,当大家趋之若鹜的通用 Agent 投入真实场景(如本次深度研究任务)时,它从 “无所不能” ,迅速变得骨感:

- “通用”≠“好用”或“高效”:Manus 工具虽多,但“研究”任务的核心是精准搜索与信息整合。过度依赖 Browser Use 这类笨重易错的工具,反而引入脆弱性,降低了任务成功率。

- “全能” 模型的路线:巨头追逐“全能大模型”有其商业逻辑。然而,“宣称全能”与“值得信赖”存在鸿沟。以人类社会举例,社会信任源于专业分工(医生、律师同理)。用户真正需要的是在特定场景下深度可靠的解决方案。一个“万能”Agent如何同时在代码、法律、医疗建立专业信任?即使有一个 “万能“ 的 Agent,人们敢信任它吗?反而应该是 “恐惧“ ?

- “专业” Agent 可落地:Gemini Deep Research 在实践中的有效性,正因其聚焦“深度研究”并做深做透。Aget的价值在于垂直领域的 “专家级助手”(如专精代码生成、法律研究、金融分析),因专注而可靠,因可靠而可用。

Leave a Reply